Prosjekter

Enten vi leverer produksjon eller konsultasjon, brenner vi for å skape det aller beste! Les mer om noen av våre prosjekter her.

10 years with Pure Arctic Oil

Film og animasjon

Film og animasjonWalkerWorld

IT-konsulenter

IT-konsulenterBulder - Fra Sparebanken Norge

Film og animasjon

Film og animasjonCollagen Booster

Film og animasjon

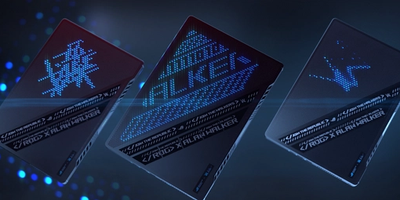

Film og animasjonASUS x Alan Walker

Film og animasjon

Film og animasjonHatting

IT-konsulenter

IT-konsulenterTV 2

Film og animasjon

Film og animasjonSynnøve

Moyka - Rear View

Film og animasjon

Film og animasjonOcean Miracle

Kontakt oss

Ikke nøl med å ta kontakt med oss. Vi er alltid klar for en uforpliktende prat.